引言

2024年,人工智能大模型技术发展迅猛,ChatGPT等AI大模型产品风靡全球。网上关于人工智能大模型的文章很多,但往往专业性太强,不太容易看懂。今天,我们就用最通俗易懂的语言,来深入解析什么是AI大模型,它是如何训练出来的,以及它能在人工智能领域做些什么。

人工智能大模型是什么?

在人工智能领域,大模型(Large Model)是一个重要概念,早期也被称为基础模型(Foundation Model)。从技术角度来说,人工智能大模型是一个包含了超大规模参数(通常在十亿个以上)的神经网络模型。

当下最受关注的AI大模型类型是大语言模型(Large Language Model,简称LLM)。除此之外,人工智能大模型家族还包括视觉大模型、多模态大模型等。业内通常将所有类型的模型统称为”广义的大模型”,而单独的语言大模型则被称为”狭义的大模型”。

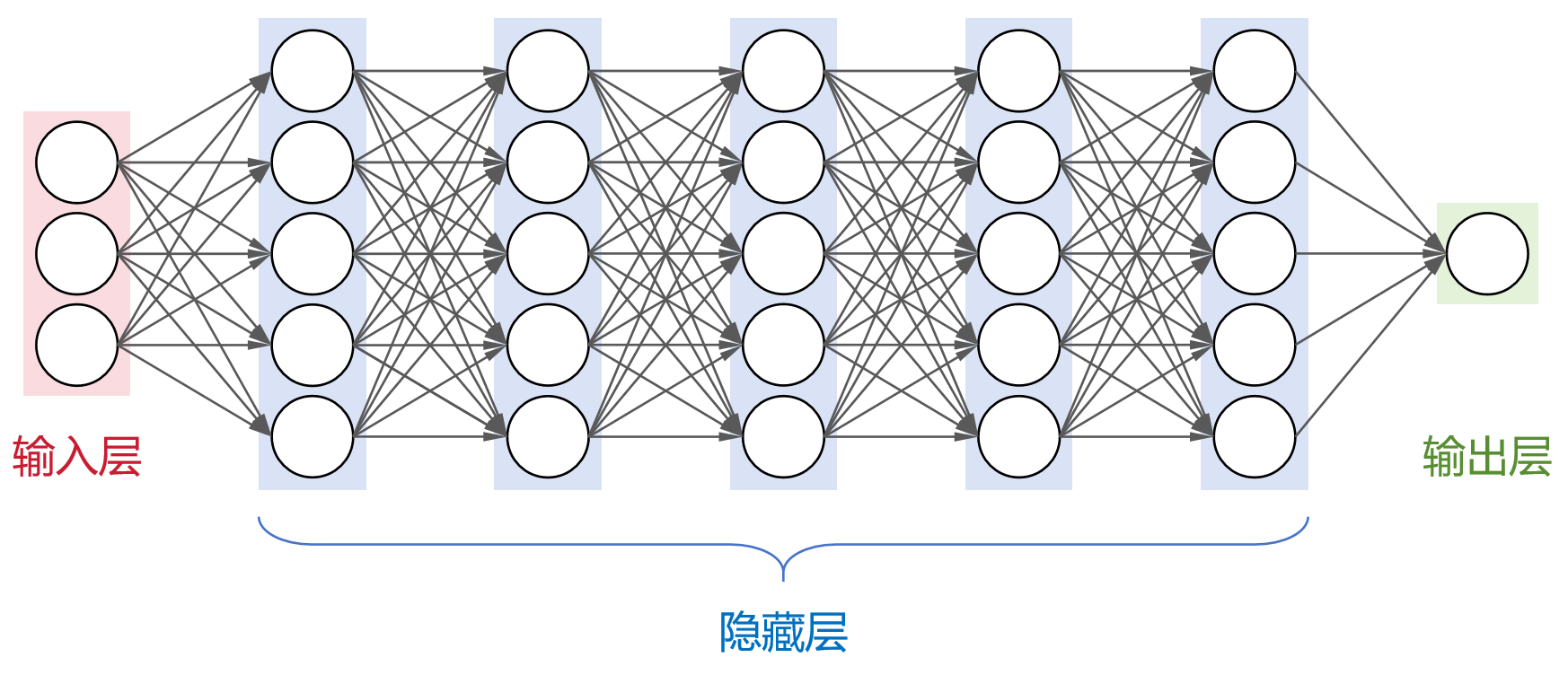

要理解AI大模型,我们需要先了解神经网络。在人工智能技术中,神经网络是最基础的计算模型,它通过模拟人类大脑中神经元的连接方式,能够从输入数据中学习并生成有用的输出。目前,主流的人工智能大模型都采用了transformer架构。

人工智能大模型之所以称为”大”,主要体现在四个方面:

- 参数规模大

- 架构规模大

- 训练数据大

- 算力需求大

以人工智能领域知名的OpenAI GPT-3为例,这个大模型具有96层隐藏层,每层都有2048个神经元。整个AI大模型的参数数量达到了惊人的1750亿。在训练数据方面,GPT-3使用了45TB的文本数据,即使经过清洗后也有570GB,包括了CC数据集(4千亿词)、WebText2(190亿词)、BookCorpus(670亿词)和维基百科(30亿词)等海量内容。

训练如此规模的人工智能大模型需要多少算力呢?根据公开数据,训练GPT-3大约需要3640PFLOP·天。如果使用512张英伟达的A100 GPU(单卡算力195 TFLOPS),也要整整一个月的时间。而且在实际AI模型训练过程中经常会出现中断,所以真实时间会更长。

相比之下,参数少于百万级的小型AI模型就显得”麻雀虽小五脏俱全”了。这些小模型虽然规模小,但胜在轻量级、高效率、易于部署,特别适合数据量较小、计算资源有限的垂直领域人工智能应用场景。

AI大模型是如何训练出来的?

了解了什么是人工智能大模型,我们来看看它是如何训练出来的。

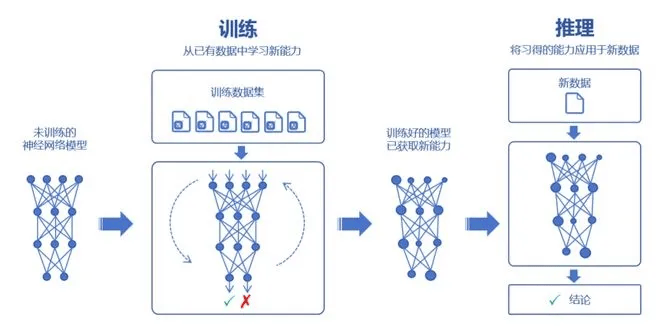

AI大模型通过对海量数据的学习来吸收”知识”,然后再把这些知识运用到实际场景中。在人工智能领域,我们把学习的过程叫做训练,运用的过程叫做推理。训练又分为两个重要环节:预训练和微调。

预训练阶段

在AI大模型预训练时,我们首先要选择一个大模型框架(比如transformer),然后用海量数据来训练,让模型学习到通用的特征表示。

那么,为什么人工智能大模型能有这么强的学习能力?为什么说参数越多学习能力就越强呢?

这要从神经元的结构说起。每个神经元的处理过程其实就是一个函数计算过程。通过输入(x)和输出(y),去求解权重(W)。在AI模型训练中,权重决定了输入特征对模型输出的影响程度。除了权重外,还有一个重要参数叫偏置(biases),可以理解为神经元对输入信号的”容忍度”。

简单来说,预训练就是通过反复输入和输出,去推算最合理的权重和偏置(也就是参数)。参数越多,人工智能大模型就能学习到更复杂的模式和特征,表现出更强的性能。

AI大模型有两个特别的能力:涌现能力和泛化能力。当模型的训练数据和参数达到一定规模后,它会突然表现出一些意想不到的能力,比如能够理解知识并进行发散思维,这就是”涌现能力”。而泛化能力,就像是读书多的人能够对没读过的书也说出一些见解一样。

不过要注意,参数越多未必就越好。过多的参数可能会导致”过拟合”,就是AI大模型变成了”书呆子”,只会死记硬背,不会融会贯通。

人工智能大模型的预训练使用的都是未标注数据,因为这种数据在互联网上很容易获取。相比之下,标注数据需要人工处理,成本太高。这些数据都要经过收集、清洗、脱敏和分类等处理,以确保数据的质量。

微调阶段

预训练完成后,我们得到的是一个通用AI大模型。但这种模型一般不能直接使用,因为它在特定任务上的表现往往不够理想。这时就需要进行微调。

微调就是用特定领域的标注数据来调整模型参数,让人工智能大模型更好地完成特定任务。微调后的模型就成了行业大模型,如果再针对更专业的领域继续微调,就成了专业大模型(也叫垂直大模型)。

大多数AI大模型研发机构一般只做预训练,而行业客户主要负责微调,这种”预训练+微调”的分阶段训练方式可以避免重复投入,节省大量计算资源,显著提升人工智能大模型的训练效率。

完成预训练和微调后,还需要对AI大模型进行全面评估。通过实际数据或模拟场景来验证人工智能大模型的性能、稳定性和准确性是否符合要求。等评估验证都完成了,这个AI大模型就算是”毕业”了,可以正式投入人工智能应用了。

在实际应用中,我们通过提问或提供提示词(Prompt)来让AI大模型回答问题或生成内容,这个过程就是推理过程。此时的人工智能大模型已经”定型”,参数不再变化,就像一个训练有素的AI助手,专注于完成交给它的任务。

AI大模型能做什么?

根据训练的数据类型和人工智能应用方向,AI大模型可以分为几类:

语言大模型是最常见的一类,它擅长自然语言处理。像风靡全球的ChatGPT就属于这类人工智能大模型,可以用来写文章、写诗、写代码,做文献分析和摘要汇总,甚至进行机器翻译。这种AI大模型极大地提升了人类在文本处理方面的效率。

音频AI大模型则专注于识别和生成语音内容,在智能语音助手、AI语音客服和智能家居控制等人工智能应用场景中发挥重要作用。

视觉AI大模型主要处理图像相关的任务,在安防监控、自动驾驶、医学图像分析等人工智能应用领域展现出强大实力。

多模态AI大模型则更为先进,它结合了文本和图像处理能力,可以实现文生图、文生视频,甚至可以通过上传图片来搜索相关的文字描述。2024年,这类人工智能大模型发展势头强劲,成为了AI技术领域关注的焦点。

在具体的人工智能应用场景中,我们还有金融AI大模型、医疗AI大模型、法律AI大模型、教育AI大模型、代码AI大模型等等,每个领域都有其特定的应用场景。比如金融AI大模型就可以用于风险管理、信用评估、交易监控、市场预测、合同审查和智能客服等多个方面。

2024年AI大模型发展趋势

截至2024年3月25日,中国拥有10亿参数规模以上的人工智能大模型已超过100个,被称为”百模大战”。不过,开发一个AI大模型的成本十分高昂。据行业估计,训练成本从几百万美元到上亿美元不等。比如GPT-3一次训练就要花140万美元,而最新的Claude 3人工智能大模型的训练费用更是高达约1亿美元。

在当前的AI大模型竞争中,真正有能力做闭源大模型的企业并不多,大部分都是基于开源框架开发的,有些甚至是为了迎合资本市场或蹭AI技术热度。目前行业里还有一些头部企业在追求更大规模的人工智能大模型,比如OpenAI、xAI等。马斯克就在X平台上宣布,xAI已经启动了由10万块H100组成的世界最强AI训练集群,主要用于开发下一代AI大模型Grok 2和Grok 3。

不过对大多数企业来说,万卡和万亿参数已经是个天花板了。随着人工智能产业逐渐趋于理性,关注点已经从”打造AI大模型”转向”应用AI大模型”。如何将人工智能大模型落地应用,如何吸引用户,如何创造商业价值,这些才是企业现在最关心的问题。

2024年AI大模型的应用正在向终端设备延伸,AI手机、AI PC、具身智能等概念越来越热。像高通、联发科这样的芯片厂商都推出了具有更强AI算力的手机芯片,OPPO、vivo等手机厂商也在终端设备中内置了AI大模型,推出了许多原生人工智能应用。目前AI相关APP的数量已达300多万款,2024年6月AIGC类APP的月活跃用户达到6170万,同比增长653%。

为了适应终端设备的资源限制,人工智能大模型也在走向轻量化,通过剪枝、量化、蒸馏等技术来减少资源需求,同时保持AI性能。这种轻量级AI大模型将推动人工智能技术更广泛地融入日常生活。

AI大模型面临的挑战

虽然人工智能大模型能够大幅提升效率,但它也像一把双刃剑,给社会带来了不少新的挑战:

首先是就业问题。AI大模型掀起的人工智能浪潮必然会导致一些传统工作岗位被替代,引发就业市场的结构性变化。

其次是知识产权问题。AI大模型生成的内容可能涉及版权争议,因为它在训练过程中”借鉴”了人类创作者的作品,这个界限很难划分。长此以往可能会影响人类的原创动力。

第三是AI伦理问题。如果训练数据本身存在偏见,人工智能大模型可能会放大这些偏见,在性别、种族、宗教等方面表现出偏差。AI生成的内容也可能被用于政治宣传和舆论操控。

第四是AI安全风险。人工智能大模型可以生成逼真的文本、图像、语音和视频,这些都可能被不法分子用于诈骗、诽谤等违法行为。

第五是能源消耗问题。AI大模型的训练和运行需要消耗大量计算资源,不仅成本高昂,还会产生大量碳排放。很多企业盲目跟风开发人工智能大模型,造成了大量资源浪费。

这些挑战涉及伦理、法律、社会和经济等多个层面,需要整个人工智能产业共同探索解决方案。

结语

2024年,人工智能大模型技术正在深刻改变我们的生活和工作方式。虽然AI大模型还面临着诸多挑战,但它无疑是推动人工智能技术进步的重要力量。相信随着技术的不断进步和应用的深入,人工智能大模型将为社会发展带来更多积极的改变!